- Engineering

- Messsysteme

- Maschinenqualifikation

-

Komponenten

-

Systeme

-

Mehr erfahren

-

- Expertise

-

Über IBS

-

Unsere Geschichte

-

Mehr erfahren

-

Bei IBS Precision Engineering haben wir uns auf Präzisionstechnik spezialisiert und nutzen die Kraft der Messtechnik, um eine beispiellose Genauigkeit in unserer Arbeit zu erreichen. Auf dieser FAQ-Seite finden Sie Antworten auf einige der am häufigsten gestellten Fragen zur Messtechnik in der Feinwerktechnik.

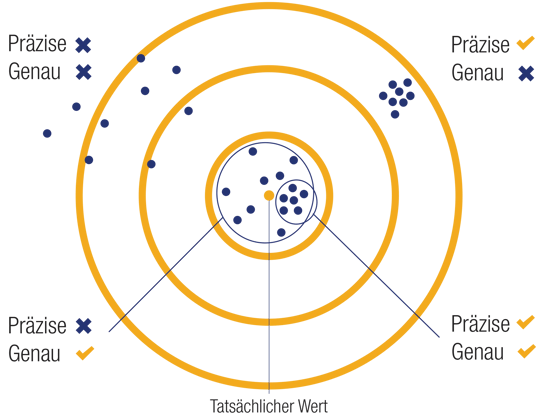

Die Genauigkeit einer Messung ist ein qualitativer Hinweis darauf, wie genau das Ergebnis einer Messung dem wahren Wert des gemessenen Parameters entspricht. Da der wahre Wert immer unbekannt ist, handelt es sich bei der Genauigkeit einer Messung immer um eine Schätzung. Eine Angabe zur Genauigkeit hat allein keinen anderen Wert als einen Indikator für die Qualität. Sie besitzt nur dann einen quantitativen Wert, wenn sie von Informationen über die Unsicherheit des Messsystems begleitet wird. Die Genauigkeit eines Messgeräts ist ein qualitativer Hinweis auf die Fähigkeit des Geräts, Antworten zu liefern, die dem wahren Wert der gemessenen Größe nahekommen. Die Genauigkeit ist eine Spezifikation des Designs und kann während der Kalibrierung überprüft werden. Die Genauigkeit der meisten Messgeräte hängt von der Genauigkeit des Geräts oder der für die Kalibrierung verwendeten Methode ab. Im Laufe der Zeit kann sich die Genauigkeit ändern. Um die richtige Genauigkeit zu gewährleisten, ist eine ordnungsgemäße Neukalibrierung der Instrumente oder Werkzeuge innerhalb eines bestimmten Zeitrahmens erforderlich.

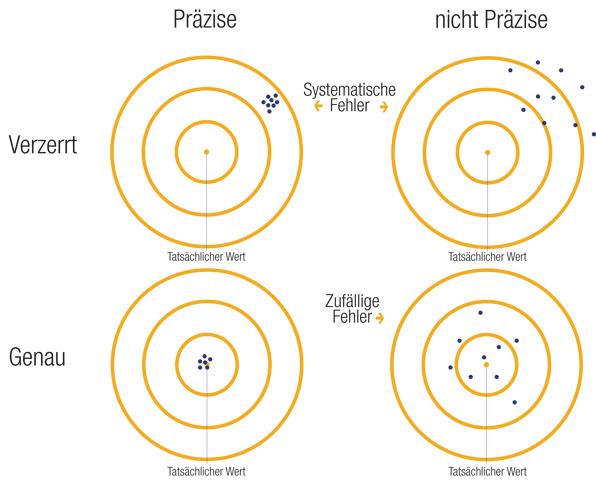

Präzision ist eine Eigenschaft eines Messsystems oder -geräts. Die Präzision ist ein Maß für die Wiederholbarkeit eines Messsystems, d. h. für die Übereinstimmung innerhalb einer Gruppe von wiederholten Messungen der gleichen Größe unter den gleichen Bedingungen. Sie bezieht sich auf den Grad der Übereinstimmung zwischen den Messergebnissen und gibt an, wie konsistent ein Prozess ist. Je besser die Präzision ist, desto geringer ist die Differenz zwischen den Werten, was auf eine hohe Wiederholbarkeit der Ergebnisse hindeutet. Eine hohe Präzision wird nur mit hochwertigen Instrumenten und sorgfältiger Arbeit erreicht. Die Präzision wird in der Regel durch die Abweichung einer Reihe von Ergebnissen vom arithmetischen Mittel der Reihe ausgedrückt.

Präzision und Genauigkeit stehen in keinem Verhältnis zueinander, d. h. man kann sehr präzise sein, aber nicht genau oder umgekehrt. Präzision wird auch als Synonym für die Auflösung der Messung verwendet, z.B. ist eine Messung, die den Unterschied zwischen 0,01 und 0,02 erkennen kann, präziser (hat eine höhere Auflösung) als eine, die nur den Unterschied zwischen 0,1 und 0,2 erkennen kann, auch wenn beide gleich genau oder ungenau sein können.

Wiederholbarkeit und Reproduzierbarkeit sind zwei Aspekte der Präzision. Die Wiederholbarkeit beschreibt die minimale Schwankungsbreite der Präzision und gibt die Abweichungen an, die auftreten, wenn die Bedingungen konstant sind und derselbe Bediener dasselbe Instrument innerhalb eines kurzen Zeitraums verwendet. Im Gegensatz dazu beschreibt die Reproduzierbarkeit die maximale Variabilität der Präzision, bei der Variationen über längere Zeiträume mit verschiedenen Instrumenten und verschiedenen Bedienern auftreten.

Wiederholbarkeit und Reproduzierbarkeit sind zwei Aspekte der Präzision.

Die Wiederholbarkeit beschreibt die minimale Variabilität der Präzision und identifiziert die Schwankungen, die auftreten, wenn die Bedingungen konstant sind und derselbe Bediener dasselbe Instrument am selben Ort innerhalb eines kurzen Zeitraums verwendet. Die Wiederholbarkeit wird in den folgenden statistischen Größen ausgedrückt: Mittelwert, Standardabweichung oder Standardabweichung des Mittelwerts. Je kleiner die Zahl ist, desto höher ist die Wiederholbarkeit und desto zuverlässiger sind die Ergebnisse.

Die Reproduzierbarkeit ist ein wichtiger Bestandteil der Schätzung der Messunsicherheit. Sie beschreibt die maximale Variabilität der Präzision, wenn Abweichungen über längere Zeiträume mit verschiedenen Instrumenten, an verschiedenen Orten oder von verschiedenen Bedienern auftreten. Sie misst die Fähigkeit, die Ergebnisse anderer zu replizieren. Mit anderen Worten: Eine Reproduzierbarkeitsmessbedingung ist eine weitere Wiederholbarkeitsprüfung, bei der eine oder mehrere Messbedingungen geändert wurden, um die Auswirkungen auf die Messergebnisse zu bewerten.

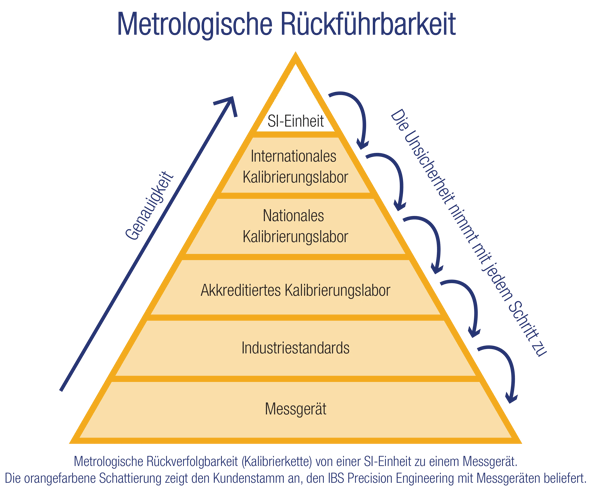

Die messtechnische Rückführbarkeit ist eine Eigenschaft eines Messergebnisses, bei der das Ergebnis durch eine dokumentierte, ununterbrochene Kette von Kalibrierungen, die jeweils zur Messunsicherheit beitragen, mit einer Referenz in Verbindung gebracht werden kann. Vereinfacht ausgedrückt ist die Rückführbarkeit die Reihe von Vergleichen der Messergebnisse des Messgeräts (Messwert und Messunsicherheit) mit dem Wert eines höheren Genauigkeitsnormals, das mit einem genaueren Normal verknüpft ist, bis es internationale Standards oder SI erreicht.

Die metrologische Kette der Rückführbarkeit ist "die Abfolge von Messnormalen und Kalibrierungen, die verwendet werden, um ein Messergebnis mit einer Referenz in Beziehung zu setzen". Sie verknüpft jedes in einem Auftrag verwendete Bezugsnormal von hohen zu niedrigen Genauigkeitswerten, bis sie die unterste Kette erreicht. Wenn eine Kette auf dem Weg unterbrochen wird, wird auch die Rückverfolgbarkeit in diesem Teil unterbrochen. Eine Rückverfolgung bis zur obersten Kette ist dann nicht mehr möglich.

Die Rückverfolgbarkeitspyramide zeigt die Hierarchie der einzelnen Bezugsnormale und die Größe der angegebenen Unsicherheit. Je höher die Position des Referenznormals in der Pyramide ist, desto geringer ist die Messunsicherheit, die es liefern kann, und desto genauer ist das Normal. Hinweis: Die Rückführbarkeit bezieht sich auf das "Messergebnis", nicht auf das Gerät, den Standard oder sogar die durchgeführte Kalibrierung.

Unter Kalibrierung versteht man den Prozess der Einstellung eines Instruments oder Messsystems, um sicherzustellen, dass es genaue und zuverlässige Ergebnisse liefert. Die Kalibrierung erfolgt in der Regel durch den Vergleich der Messwerte des Geräts oder Systems mit bekannten oder rückführbaren Standards und die Vornahme der erforderlichen Anpassungen, um die Messwerte mit den Standards in Übereinstimmung zu bringen. Der Zweck der Kalibrierung besteht darin, sicherzustellen, dass das Gerät oder System innerhalb seiner spezifizierten Genauigkeit arbeitet und Messunsicherheiten minimiert werden. Die Kalibrierung wird mit dem zu kalibrierenden Gerät in seiner normalen Betriebskonfiguration durchgeführt - so wie es der normale Bediener verwenden würde.

Das Ergebnis einer Kalibrierung ist eine Bestimmung der Leistungsqualität des Geräts in Bezug auf die gewünschten Spezifikationen. Dies kann in Form einer Pass/Fail-Entscheidung, der Bestimmung oder Zuweisung eines oder mehrerer Werte oder der Festlegung einer oder mehrerer Korrekturen erfolgen. Die Kalibrierung erfolgt nach einem festgelegten dokumentierten Kalibrierverfahren, unter festgelegten und kontrollierten Messbedingungen und mit einem festgelegten und kontrollierten Messsystem.

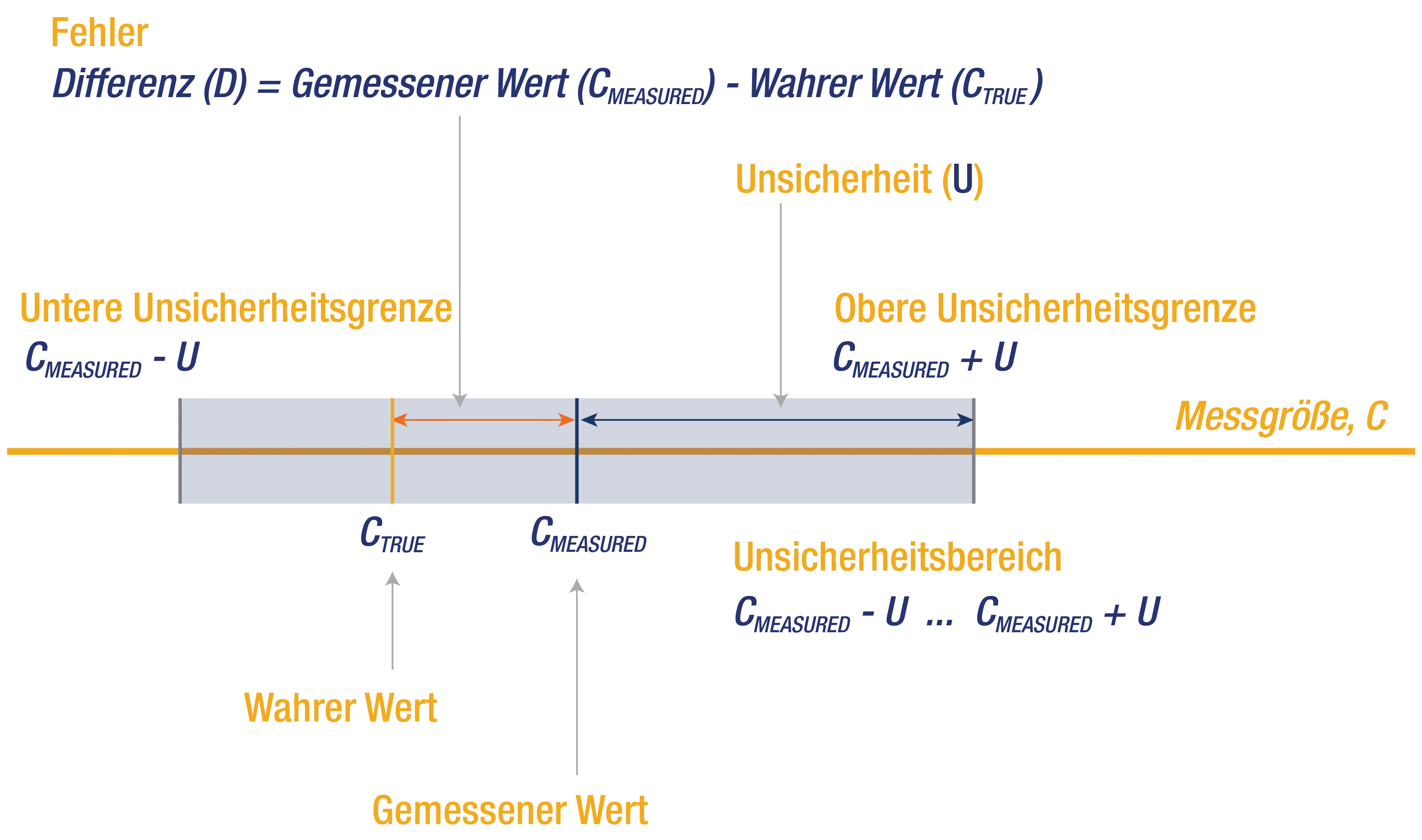

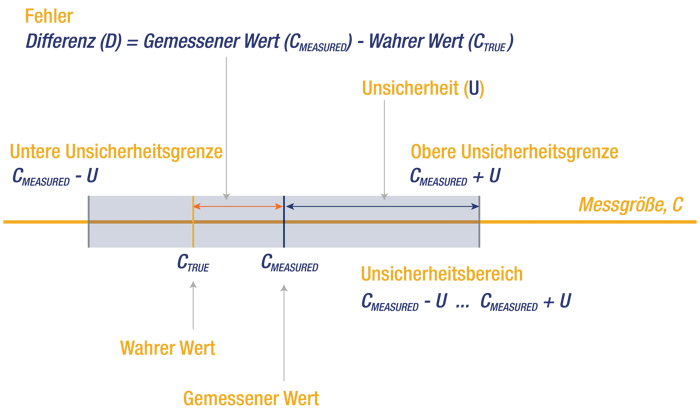

In der Metrologie ist der Fehler (oder Messfehler) eine Schätzung der Differenz zwischen dem gemessenen Wert und dem wahrscheinlichen wahren Wert des Messobjekts. Der Fehler kann nie genau bekannt sein; es handelt sich immer um eine Schätzung. Der Fehler kann systematisch und/oder zufällig sein.

Ein systematischer Fehler ist der Mittelwert einer großen Anzahl von Messungen desselben Wertes abzüglich des (wahrscheinlichen) wahren Wertes der gemessenen Größe. Der systematische Fehler bewirkt, dass der Durchschnitt der Messwerte vom wahren Wert abweicht. Der systematische Fehler ist ein Maß für die Größenordnung und kann korrigiert werden. Der systematische Fehler wird auch als Verzerrung bezeichnet, wenn er sich auf ein Messgerät bezieht.

Systematische Fehler

Die Zufallsabweichung ist das Ergebnis einer einzelnen Messung eines Wertes abzüglich des Mittelwertes einer großen Anzahl von Messungen desselben Wertes. Die zufällige Messabweichung verursacht Streuungen in den Ergebnissen einer Reihe von Messungen und ist daher ein Maß für die Dispersion.

Zufällige Fehler:

Die Messunsicherheit ist der nicht-negative Parameter, der die Dispersion der einer Messgröße zugeordneten Größenwerte auf der Grundlage der verwendeten Informationen charakterisiert. Einfacher ausgedrückt, ist die Messunsicherheit die Schätzung des Wertebereichs, in den der wahre Wert einer Messgröße wahrscheinlich fällt. Messunsicherheit und Genauigkeit sind eng miteinander verbunden, aber unterschiedliche Konzepte. Die Genauigkeit bezieht sich darauf, wie nahe ein gemessener Wert am wahren Wert liegt, während die Messunsicherheit eine Schätzung ist, wie stark der gemessene Wert aufgrund von Faktoren wie zufälligen Fehlern, systematischen Fehlern und Beschränkungen der Messmethode oder des Messgeräts vom wahren Wert abweichen kann. Eine Messung kann genau sein, aber eine hohe Unsicherheit aufweisen, wenn der Bereich der möglichen Werte groß ist. Andererseits kann eine Messung weniger genau sein, aber eine geringere Unsicherheit haben, wenn der Bereich der möglichen Werte klein ist.

Um die Messunsicherheit zu bestimmen, müssen mehrere Faktoren berücksichtigt werden.

Richtlinien wie der "Guide to the Expression of Uncertainty in Measurement" (GUM) bieten einen Rahmen für die Schätzung und Angabe der Messunsicherheit.

Bei der Auswahl des richtigen Messgeräts für eine bestimmte Aufgabe sollten mehrere wichtige Aspekte berücksichtigt werden:

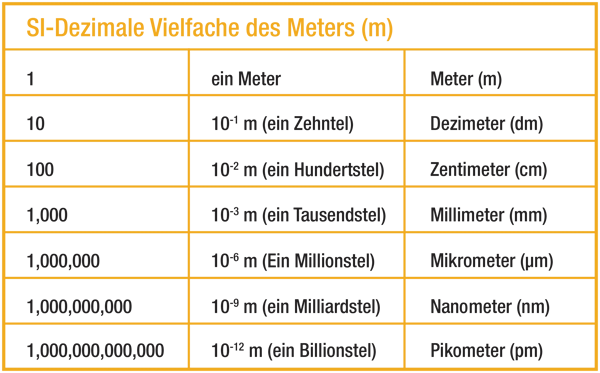

Ein Pikometer ist eine Längeneinheit im Internationalen Einheitensystem (SI). Es entspricht einem Billionstel (1/1.000.000.000.000) eines Meters oder 10^(-12) Metern. Das Symbol für das Pikometer ist "pm". Es ist unglaublich klein und wird in der Regel verwendet, um die Größe von Atomen, Molekülen und deren Wechselwirkungen zu messen.

Um eine Vorstellung von seiner Größe zu vermitteln: